機械学習で文章から画像を生成するライブラリを手元のWindows10で動かしてみたメモ

準備

基本的にはMMVCを動かしたときと同様下記をインストール。

Anaconda3-2021.05 (python 3.8.8のもの)

git (source treeに同梱されているものでも可)

インストール

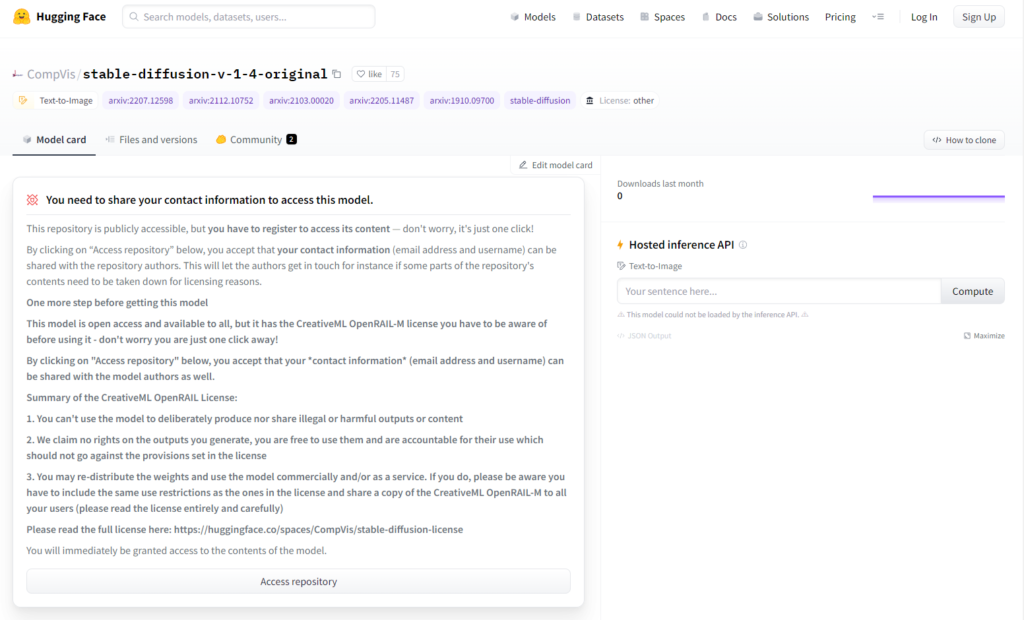

まず学習済みモデルをダウンロードするためにここでユーザ登録する。

ユーザ登録した際のユーザIDとパスワードを控えておく

右上にあるSign Upでユーザ登録ができる

その後Access repositoryを押してモデルのリポジトリにアクセスできるようにしておく

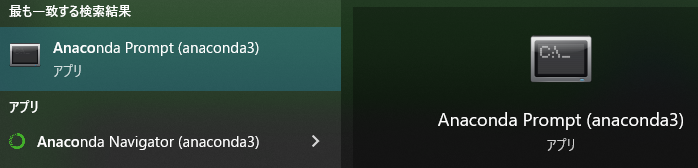

Anaconda Promptを開く

curl -u mailaddress:password のmailaddressとpasswordの箇所には、先ほど控えたユーザIDとパスワードを入れるgit clone https://github.com/basujindal/stable-diffusion.git

cd stable-diffusion

conda env create -f environment.yaml

conda activate ldm

cd models/ldm

mkdir stable-diffusion-v1

cd stable-diffusion-v1

curl -u mailaddress:password -o model.ckpt -L https://huggingface.co/CompVis/stable-diffusion-v-1-4-original/resolve/main/sd-v1-4.ckpt

cd ../../../

python scripts/txt2img.py --prompt "a photograph of an astronaut riding a horse" --plms しばらく待つとこのようなエラーが出た場合は

RuntimeError: CUDA out of memory. Tried to allocate 3.00 GiB (GPU 0; 8.00 GiB total capacity; 5.62 GiB already allocated; 0 bytes free; 5.74 GiB reserved in total by PyTorch) If reserved memory is >> allocated memory try setting max_split_size_mb to avoid fragmentation. See documentation for Memory Management and PYTORCH_CUDA_ALLOC_CONFVRAM容量不足なので軽量版を実行する

python optimizedSD/optimized_txt2img.py --prompt "Cyberpunk style Tokyo landscape" --H 512 --W 512 --seed 27 --n_iter 2 --n_samples 10 --ddim_steps 50

outputs/txt2img-samples/Cyberpunk_style_Tokyo_landscapeディレクトリ以下にこのような画像が出力されていれば成功